腾讯云 EdgeOne AI 网关是一款为访问大语言模型(LLM)服务商提供安全、可见性和请求行为控制管理的工具。本文将详细介绍其功能、使用方法和典型场景,帮助您快速上手。

什么是 AI 网关?

功能概览

腾讯云 EdgeOne AI 网关为访问大语言模型 (LLM) 服务商提供了安全、可见性和请求行为控制管理。目前,AI 网关已开放给开发者申请免费试用。

AI 网关已支持缓存配置功能,正在开发的功能包括限流 (rate limiting)、请求重试 (request retries)、LLM 模型回退 (LLM model fallback) 和虚拟密钥 (virtual keys)。这些功能的组合将有效保障访问 LLM 服务商的安全性和稳定性,同时降低访问成本。

注意:该功能目前处于 Beta 版本,我们不建议在生产环境中使用。如果您希望在生产业务中试用,请在使用前仔细评估业务风险。

适用场景

- 企业办公:适合企业管理者在员工和 LLM 服务商之间设立 AI 网关,以控制员工对 LLM 服务商的安全访问和成本。

- 个人开发:适合 AIGC 个人开发者在消费者用户和 LLM 服务商之间设立 AI 网关,以控制消费者的请求行为。

功能优势

- 降低成本:利用缓存技术,重复的 Prompt 请求将直接由缓存提供响应,无需再次调用 LLM 服务商,从而有效避免不必要的重复成本,显著降低您的运营开销。

- 灵活配置:可配置请求重试、限流和 LLM 模型回退等功能,以处理各种异常和复杂场景,确保服务可用性。

- 数据监控:通过数据仪表盘,您可以获取 AI 网关请求的详细统计信息。这些数据将帮助您洞察流量模式、优化业务流程,并做出更精准的业务决策。

- 高安全性:虚拟密钥技术提供额外的安全层。此机制确保您的 LLM 服务商访问密钥不会泄露,从而保护您的数据安全和业务隐私。

支持的 LLM 服务商

已支持 OpenAI、Minimax、月之暗面 (Moonshot AI)、Gemini AI、腾讯混元、百度千帆、阿里通义千问和字节豆包等主流模型服务商,更多服务商正在陆续接入中。

需要特别说明的是,在这些支持的模型服务商中,Gemini API 目前是唯一可以免费使用的 AI API。这意味着您可以在无需额外成本的情况下,直接通过腾讯云 EdgeOne AI 网关调用 Gemini 提供的大语言模型服务,非常适合进行学习、测试和个人项目的开发。

操作指南

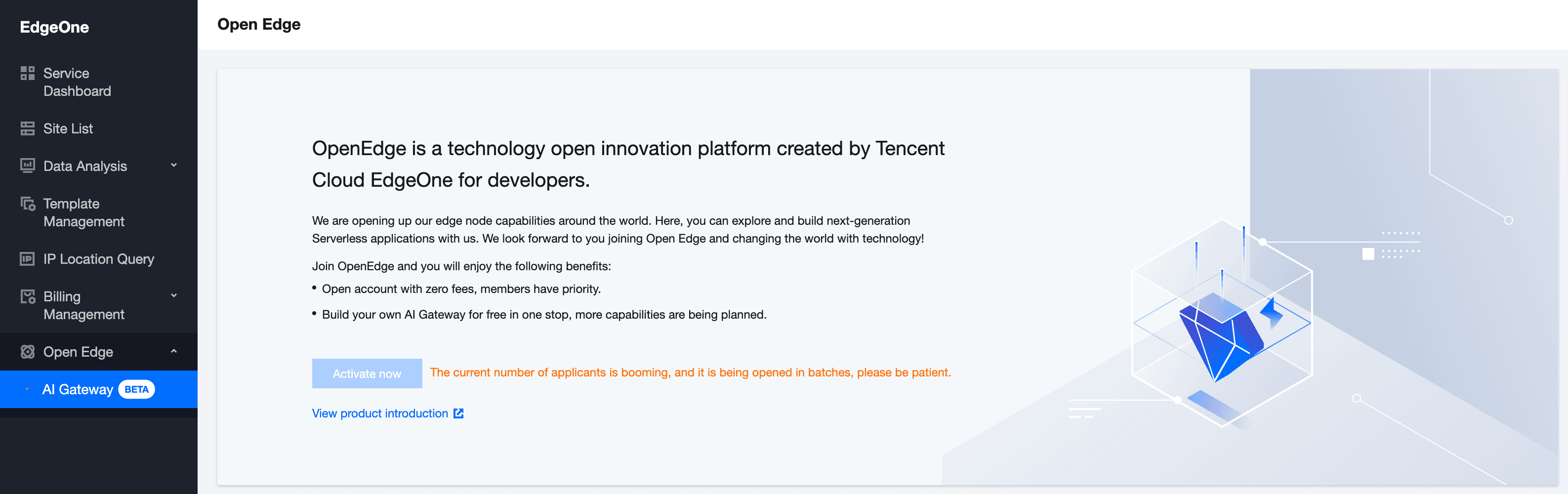

1. 激活 Open Edge

访问 腾讯云 EdgeOne 控制台,在左侧边栏点击 Open Edge。如果您之前未申请过访问权限,需要点击“立即激活”来请求使用权限。

注意:由于我们目前正在分批进行有限用户测试,如果您的申请暂未获批,请耐心等待后续更新。

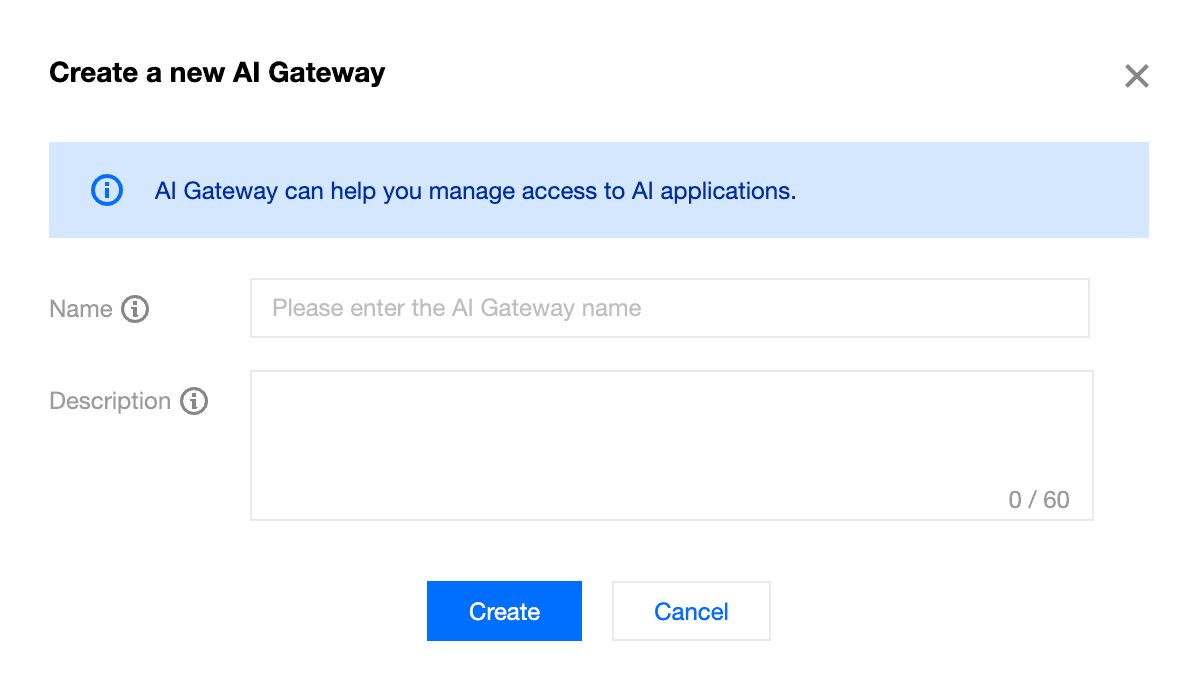

2. 创建 AI 网关

激活成功后,进入 AI 网关列表页面,点击“创建”。按照弹窗提示完成名称和描述的输入。

- 名称:必填项,创建后不可修改,只能包含数字、大小写字母、连字符和下划线;不允许重名。

- 描述:选填项,最大长度为 60 个字符。

3. 配置 AI 网关

成功创建 AI 网关后,进入 AI 网关列表页面,点击“详情”或具体的 AI 网关实例 ID,进入网关详情页。目前支持缓存配置。

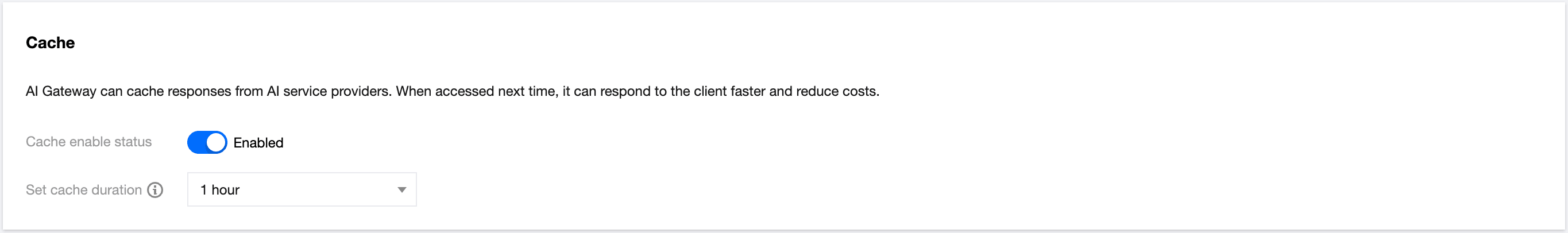

- 启用/禁用:打开开关启用缓存,网关将对相同的 Prompt 请求直接从缓存响应,无需请求 LLM 服务商。关闭开关则禁用缓存,每次请求都将由 LLM 服务商处理。

- 设置缓存时长:支持的缓存时长包括 2 分钟、5 分钟、1 小时、1 天、1 周和 1 个月。达到设定时长后,缓存将自动清除。

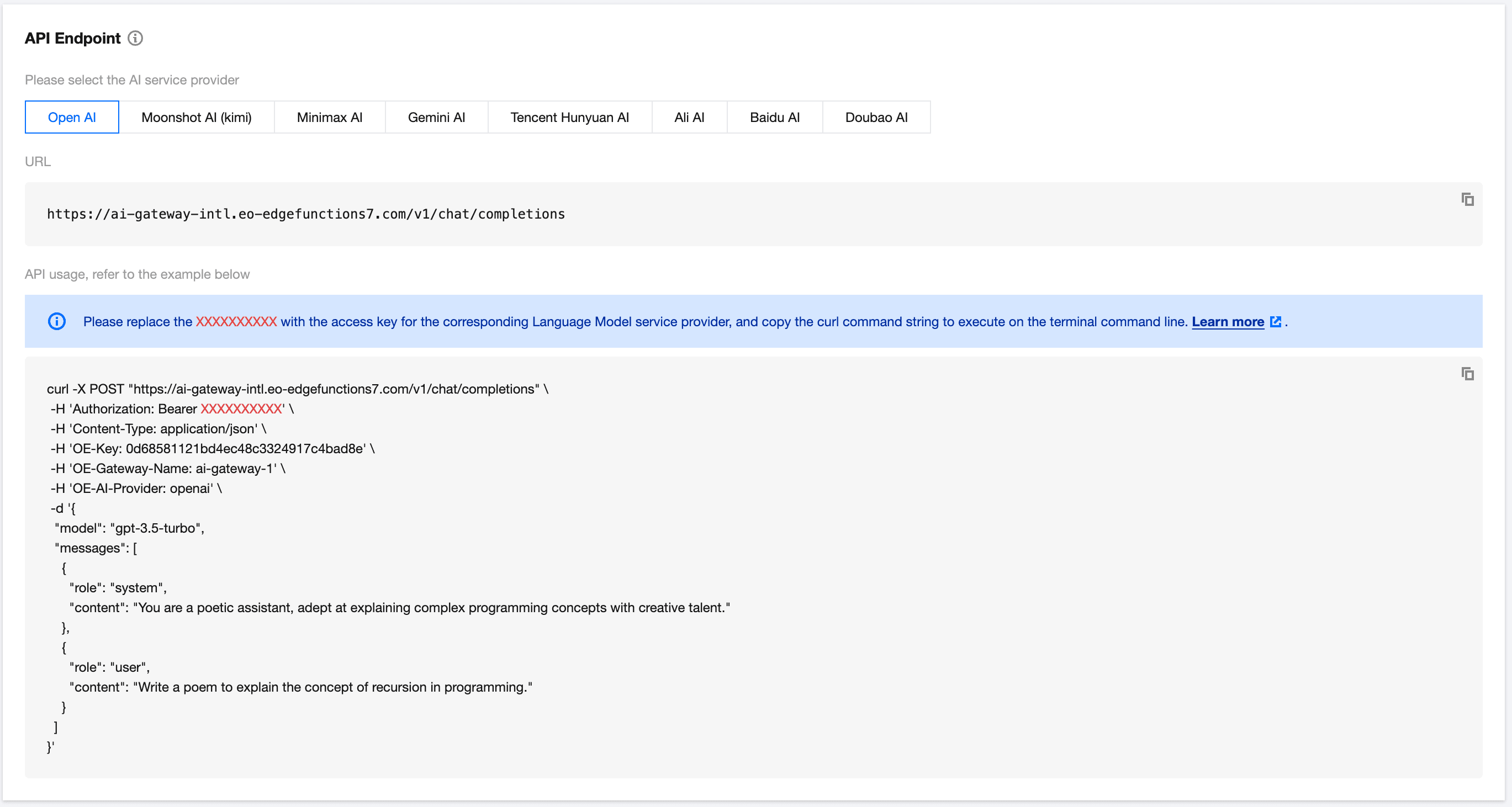

4. API 端点 (Endpoint)

AI 网关后端的相应端点 (Endpoint) 是大语言模型 (LLM) 服务商。您可以参考示例,将 Bearer xxxxxxxxxxxxxxxxxxxxxxxx 替换为服务提供商的访问密钥,例如 OpenAI 的端点。

案例演示

通过 AI 网关访问 OpenAI

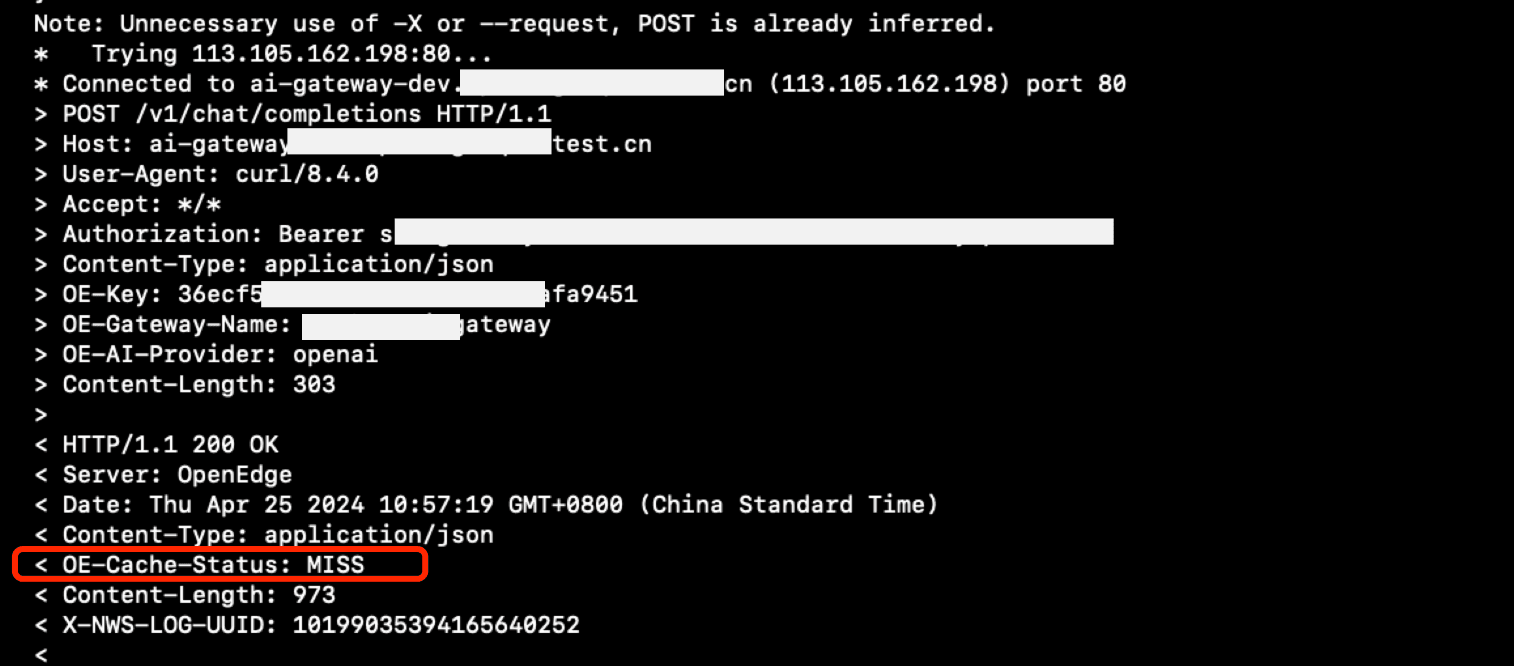

操作场景:在 AI 网关中禁用缓存,并通过 AI 网关访问 OpenAI。

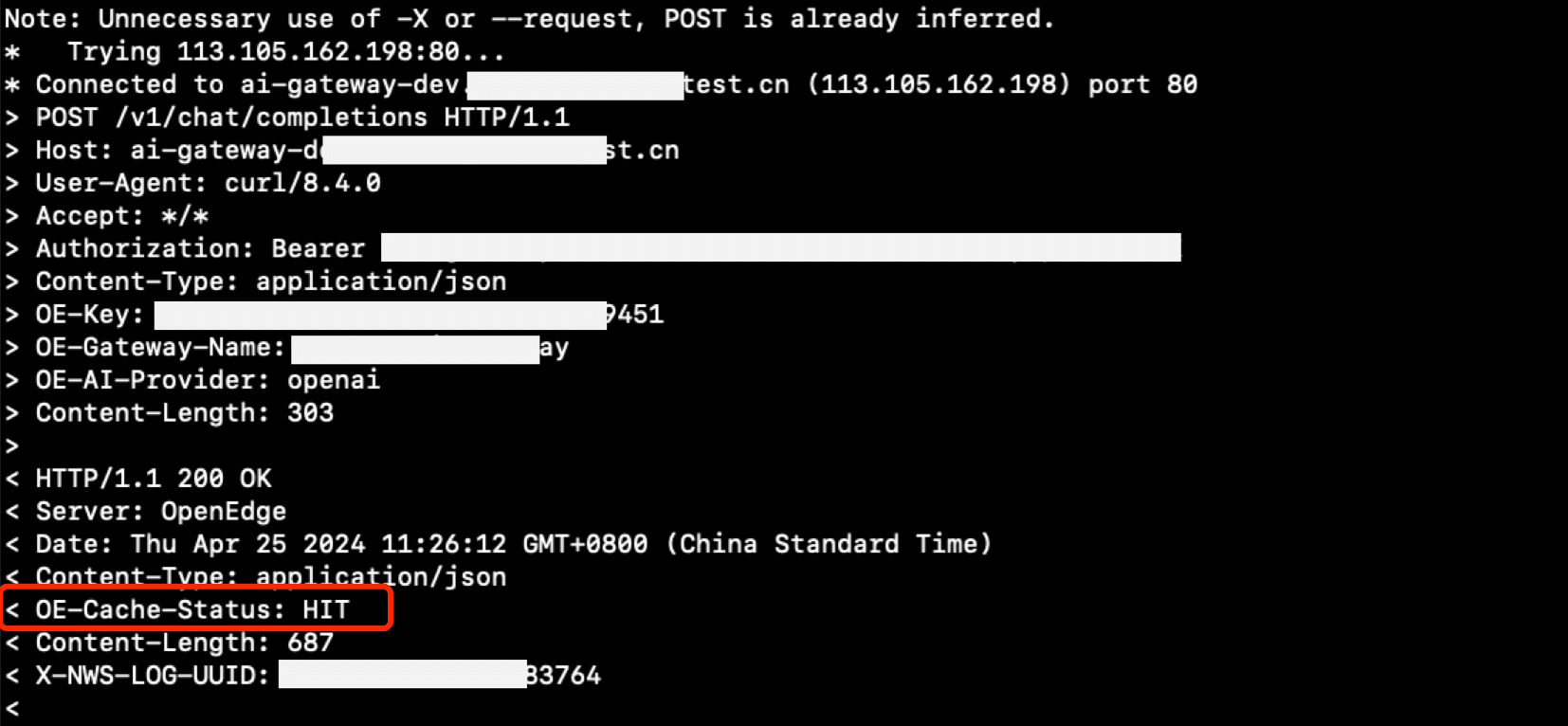

接着,在 AI 网关中启用缓存,并再次访问。

如果响应头 OE-Cache-Status 返回 HIT,则表示缓存已命中。

通过 AI 网关访问其他 LLM 服务商的步骤与上述类似。

FAQ

1. AI 网关是免费的吗? 是的,AI 网关现已开放给开发者申请免费试用。

2. AI 网关能做什么? AI 网关可以管理和控制对大语言模型 (LLM) 的访问,目前支持 OpenAI、Minimax、Moonshot AI 和 Gemini AI 等主流模型服务商。

关于

关注我获取更多资讯