随着 AI 技术的飞速发展,AI 编程助手已成为开发者提升效率不可或缺的工具。其中,OpenCode 和 Claude Code 是两款备受关注的解决方案。OpenCode 自称能提供 Claude Code 的所有魔力,同时避免了供应商锁定(vendor lock-in),这是一个大胆的承诺。那么,这款开源替代方案能否与封闭生态的竞争对手匹敌?

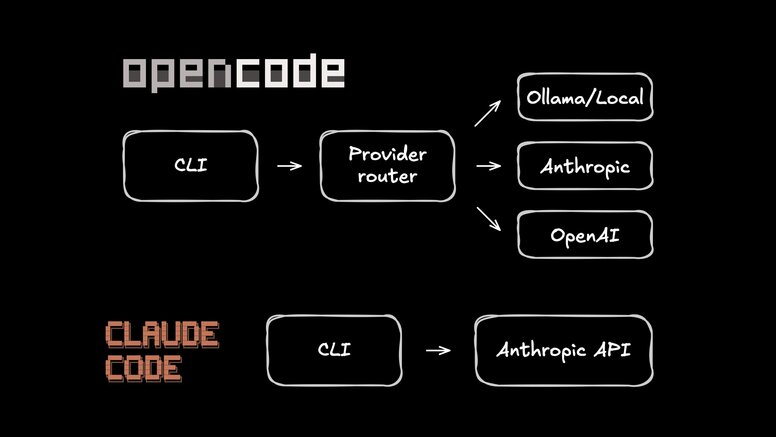

这两款工具都允许你与代码库对话、运行终端命令,并无需离开命令行即可交付功能。它们之间最显著的区别在于:Claude Code 将你严格绑定在 Anthropic 的生态系统中,而 OpenCode 则提供了极大的灵活性,允许你切换不同的服务提供商、运行本地模型,甚至使用你已经付费的 API 密钥。

这种灵活性听起来非常吸引人,但开源工具有时会给人一种“实验性”的感觉。本文将通过一系列严苛的测试,深入探究 OpenCode 的自由度是否以牺牲成熟度为代价,并对比两者在功能、性能、成本和安全性等方面的表现。

OpenCode 与 Claude Code 的核心差异

将 Claude Code 想象成 AI 编程助手领域的“Apple”模式。它是 Anthropic 官方的 CLI 工具,用户体验非常完善和流畅。它能安全地扫描你的代码仓库并处理代码编辑,但你需要遵守 Anthropic 的规则。你被锁定在他们的生态系统中,无法随意切换到 GPT 或尝试运行本地模型。尽管存在一些社区驱动的代理项目作为使用其他模型的变通方案,但它们通常不稳定且不受官方支持。

OpenCode 则是来自 SST 团队的开源替代方案。它将用户界面与 AI 模型解耦,让你能够接入超过 75 种不同的提供商。

OpenCode 的杀手级特性是其灵活性。在理想情况下,这还包括了订阅经济性:一次认证,复用你已付费的套餐,从而免去按 Token 计费的焦虑。

然而,最近 Anthropic 似乎将其 OAuth 凭据限定于 Claude Code 本身,导致第三方客户端无法使用,这提醒我们:认证机制是由策略而非物理定律决定的。提供商可以将其凭据限定于特定的第一方客户端。当这种情况发生时,第三方工具只能退回到更可靠但传统的方式:使用 API 密钥(或者切换提供商)。

这种灵活性的权衡是其成熟度。OpenCode 的迭代速度很快,这意味着你可能会遇到一些偶发性的 Bug。但如果你愿意为了运行任何模型的自由度而容忍一些不完善之处,它无疑是一个极具吸引力的选择。

功能对比:细致入微的差异

| 维度 | Claude Code | OpenCode |

|---|---|---|

| 源代码 | 专有 | MIT 开源 |

| 模型支持 | 仅支持 Claude 模型 | 支持 75+ 种提供商,包括 Ollama 本地模型 |

| 订阅认证 | 原生支持 (Pro/Max) | 多样化 (Zen 计划 + BYOK。部分 OAuth 流程不稳定) |

| 定价 | 20-200 美元/月 或 按 API 使用量付费 | 工具免费。根据你选择的提供商付费 |

| 桌面/Web | 研究预览版 | 桌面应用 (Beta) |

| IDE 插件 | VS Code, JetBrains | VS Code |

| 架构 | CLI 工具 | 客户端/服务器 + HTTP API |

| MCP 配置 | 会话切换、懒加载 (实验性功能) | 每个 Agent 的全局模式(Glob Patterns)配置 |

| 本地模型 | 不支持 (存在变通方案) | 支持 (原生集成 Ollama) |

架构选择是一个重要的考量点。OpenCode 的客户端/服务器设计支持一些高级功能,例如在远程 Docker 容器中运行会话。SST 团队正积极构建“工作区(Workspaces)”功能,即使你关闭笔记本电脑,会话也能保持持久化——这种工作流是 Claude Code 简单 CLI 设计无法支持的。

实战对比:同一模型,不同策略

纸上谈兵不如真刀真枪。我进行了一项小实验:让这两款工具进行一场正面较量。为了确保公平,我使用了完全相同的模型(Claude Sonnet 4.5),并在全新的 Docker 容器中运行所有测试,以避免任何本地配置偏差。

测试方法

- 代码仓库:一个中等规模的 TypeScript/Node.js 项目,包含现有测试。

- 模型:两款工具均使用 Claude Sonnet 4.5。

- 环境:全新的 Docker 容器,无任何预配置或历史记录。

- 评估标准:任务完成度、耗时、权限提示、代码差异质量以及故障恢复能力。

测试任务

任务 1:跨文件重命名(严苛测试)。 这是一个容易出错的任务。跨多个文件重构全局变量是衡量 AI Agent 能力的最终试金石。

提示:“在此代码库中找到 user_id 的所有定义和使用。将其全部重命名为 userId,遵循驼峰命名法(camelCase)。确保代码仍然能够编译。”

任务 2:修复 Bug。 我喜欢这个任务,因为它非常贴近实际开发。我在项目中隐藏了一个类型错误,看看这些工具是否能在无人干预的情况下找到并修复它。 提示:“此项目存在一个类型错误。找到并修复它。运行 TypeScript 编译器进行验证。”

任务 3:重构代码。 是时候清理一些技术债务了。我要求模型将重复的模糊匹配逻辑抽象成一个共享的辅助函数。

提示:“suggestEnumValue 和 suggestFieldName 函数共享相似的模糊匹配逻辑。将通用模式提取到一个共享的辅助函数中。”

任务 4:编写测试。 这是一项许多开发者不愿做的“苦差事”。我指向一个未经测试的模块,看看它们是否能模仿现有的测试模式来编写全面的单元测试。

提示:“validators.ts 模块没有测试。使用现有测试模式为所有导出的函数编写全面的单元测试。”

测试结果总览

| 任务 | Claude Code | OpenCode | 赢家 |

|---|---|---|---|

| 跨文件重命名 | 代码重命名,注释保留 (3分 6秒) | 所有内容重命名 (3分 13秒) | 取决于具体需求 |

| Bug 修复 | 正确修复 (41秒) | 正确修复 (40秒) | 平局 |

| 代码重构 | 清晰重构 (2分 10秒) | 重构 + 修复无关类型错误 (3分 16秒) | 平局 |

| 编写测试 | 73 个测试 (3分 12秒) | 94 个测试 (9分 11秒) | OpenCode |

| 总耗时 | 9分 9秒 | 16分 20秒 | Claude Code |

总结一下:Claude Code 旨在追求速度,而 OpenCode 则更注重彻底性。

深入分析:重命名任务与测试编写

在重命名任务中,两款 AI Agent 都完美地完成了实际的代码重命名:变量、参数、接口等,构建也立即通过。真正的区别在于它们如何处理可读性部分。

Claude Code 采取了更细致的方法。它保留了 JSDoc 注释和解释性文本,并指出保留它们是因为它们引用的是概念,而非特定的变量名。它将文档视为独立于代码逻辑的层。

OpenCode 则彻底进行了更改。它重命名了所有内容,包括注释。Claude 将“Initialize the user context with the given user_id”保留,而 OpenCode 则将其更新为“Initialize the user context with the given userId”。

那么,哪种方式是正确的?老实说,这取决于你的团队偏好。如果你的注释作为 API 文档被其他工具解析,OpenCode 节省了你手动清理的麻烦。如果它们只是内部注释,保留原始术语可能更清晰。值得注意的是,两款工具都没有“遗忘”文件,它们只是做出了不同的选择。

在测试编写任务中,乍一看 OpenCode 似乎比较慢:9 分钟对 Claude 的 3 分钟。但如果你深入分析,就会发现时间花在了哪里。

OpenCode 运行了 pnpm install 以确保依赖项是最新的,然后执行了整个测试套件以保证没有回归问题。它编写了 94 个测试用例,并确认它们与现有的 200 多个测试用例协同工作。

Claude Code 则以速度为优先。它编写了 73 个测试,验证了这些特定的测试通过,然后就收工了,没有运行完整的测试套件。

两种策略都有其适用之处。Claude Code 假设基线是可用的,并追求快速完成。OpenCode 则假设世界是混乱的,并在签署之前验证整个系统。

MCP 与上下文管理:Token 消耗的隐性成本

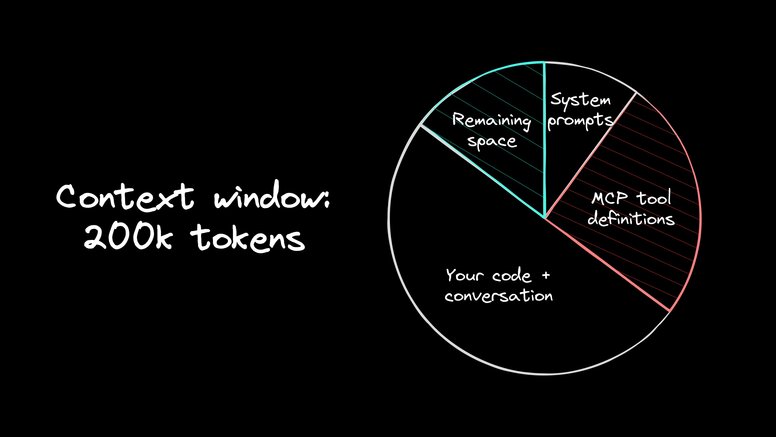

两款工具都支持模型上下文协议(Model Context Protocol, MCP),用于连接 GitHub 或 Postgres 等外部服务。这是一个强大的功能,但很少有人谈论其隐性成本:上下文污染。

为什么 AI Agent 的 MCP 上下文至关重要?

问题是这样的:当你启用一个 MCP 服务器时,它会立即将所有可用的工具定义转储到模型的上下文(context)中。仅 GitHub 服务器就会增加约 15 个工具。一个数据库服务器还会增加十几个。

在我的测试中,运行七个活跃的服务器,在用户输入提示之前,就消耗了 200k Token 窗口的 25%。按照 Claude Opus 4.5 的定价,你每个会话会烧掉大约 1.25 美元的现金,用于你可能根本不会用到的工具。

Claude Code 的 MCP 处理方式

Claude Code 采取了手动方式。你通过 CLI (claude mcp add) 添加服务器,并通过 /mcp 切换其开启或关闭状态。如果你想要严格的隔离,就不得不手动管理配置文件和参数。

有一个救星:如果你设置 ENABLE_EXPERIMENTAL_MCP_CLI=true,它会懒加载(lazy-load)工具,而不是一次性全部加载。这大大有助于降低开销。但你仍然无法为不同的任务创建持久化的配置文件。而且,这个功能尚处于活跃开发阶段。

OpenCode 的 MCP 处理方式

OpenCode 将工具更像是 package.json 中的依赖项来处理。你在 opencode.jsonc 中进行设置,并使用 Glob Patterns 来控制哪些 Agent 可以访问哪些工具。

这种声明式风格保持了上下文的干净。你可以只将特定工具注入到需要它们的 Agent 中,而不是将整个工具箱都倾倒到每次对话中。

MCP 结论

如果你只连接一两个服务,两款工具都适用,你不会注意到上下文膨胀。但如果你正在构建一个包含 GitHub、Sentry 和数据库访问的复杂堆栈?OpenCode 的方法可以有效防止上下文窗口失控。

定价策略:订阅与按量付费的博弈

老实说:API 成本是 Agentic 工作流的“隐形杀手”。当你让 LLM 对复杂的重构进行循环操作时,费用会迅速飙升。使用像 Claude Opus 这样的顶级模型进行一天的繁重编码,可能会烧掉 20 到 50 美元。如果每天都这样做,你将面临每月 1,000 美元的账单。

如果你是一家由风投支持的初创公司,这可能没什么。但如果你是独立开发者?这会很吃力。

订阅模式改变了这种局面。

订阅模式的价值

Anthropic 的 Max 20x 计划每月花费 200 美元,但计算表明它提供了大约 2,600 美元的 API 积分价值。你实际上是以 90% 的折扣购买计算资源。

这曾是 OpenCode 最亮眼的地方:订阅 OAuth。如果你能一次认证,并在所有地方复用你每月 20-200 美元的计划,那将彻底消除按 Token 计费的焦虑。

但这种优势可能会一夜之间消失。最近,有人报告称 Anthropic 返回了一个错误,例如:“此凭据仅授权用于 Claude Code,不能用于其他 API 请求。”这意味着,如果你想在 OpenCode 中可靠地使用 Claude,你需要假定使用 API 密钥并支付 API 费率(或者选择其他提供商)。

话虽如此,OpenCode 也没有停滞不前。他们推出了 OpenCode Black——一个每月 200 美元的“使用任何模型”的限量版套餐。

其他选择

目前也存在 ChatGPT Plus 和 Gemini Advanced 的社区插件,不过这些尚未得到官方支持。

本地模型支持:隐私与成本的考量

驱动本地模型使用的原因有两个:隐私和成本。你的代码可能受到合规性锁定,不能离开公司网络,或者你希望摆脱按 Token 计费的模式。

OpenCode 与 Ollama

OpenCode 在这方面表现出色。因为它支持任何兼容 OpenAI 的提供商,你可以启动 Ollama,将配置指向 localhost,然后就可以开始使用了。

现实考量:本地模型的局限性

但实际情况是:你的笔记本电脑不是数据中心。物理限制依然存在,当你切断云端连接时,就会面临一些权衡。

- 工具调用(Tool Calling)的成功率参差不齐。 较小的模型通常难以输出干净的 JSON 或找到正确的参数。它能工作,但可能不稳定。

- Agent 内存消耗大。 复杂的工作流会消耗大量的上下文(context)。大多数本地模型默认的 8,000 Token 窗口很快就会不足,因此请立即在 Ollama 中增加

num_ctx。 - 速度会变慢。 云端推理感觉是即时的。本地推理?预计会听到风扇噪音,并且启动速度会较慢。

安全与权限控制:警惕 AI 的“权力”

老实说:让 LLM 访问你的 Shell 就像给蹒跚学步的孩子一个电钻。它能很快完成工作,但你需要密切关注。

能够读取文件和运行终端命令的工具是巨大的生产力倍增器,但如果你不小心,它们也可能成为巨大的安全隐患。

Claude Code 的安全策略

Claude Code 采取了“宁可安全勿冒险”的方法。它默认是只读模式,并在写入文件或运行命令之前请求你的批准。是的,这增加了摩擦,但这种摩擦是唯一能阻止你意外执行 rm -rf 的屏障。

我非常喜欢计划模式(Plan Mode)。它能锁定 Agent,使其可以分析你的架构并绘制遗留代码,而不会有破坏任何东西的风险。

如果你喜欢冒险,可以使用 --dangerously-skip-permissions 标志关闭安全网。我只会在一次性容器中运行它,在那里我不在乎如果出现问题会怎样。Anthropic 正在努力实现更深层的沙箱隔离,以使其更流畅,但目前,提示的存在是有原因的。

OpenCode 的安全策略

OpenCode 强调透明度。由于它是开源的,你的安全团队可以审计代码。你完全掌控它在哪里运行以及它接触到什么。

其路线图包括在 Docker 或云沙箱中运行会话的“工作区(Workspaces)”功能。虽然这是一个便利功能,但其安全影响巨大:它将 Agent 与你的主机操作系统隔离。

在真空中,没有一款工具是完美安全的。Claude 通过软件限制为你提供安全保障。OpenCode 则通过基础设施控制为你提供安全保障。选择一个适合你风险承受能力的产品。

快速上手:选择你的起点

Claude Code 易于启动运行。运行 npm install 后,它会处理与你的 Anthropic 账户的认证。如果你已经是 Pro 或 Max 计划的用户,CLI 会立即识别。此外,他们还为 VS Code 和 JetBrains 提供了官方扩展。这里还有更多 Claude Code 的技巧和窍门。

OpenCode 采取了稍微不同的方法。你通过 curl 安装它,然后它会引导你选择你的提供商。如果一个认证方法停止工作,你可以切换提供商或退回到标准的 API 密钥。它还提供桌面应用和 VS Code 扩展。

简而言之:Claude Code 让你更快地实现“Hello World”。OpenCode 则要求你进行更多的前期设置,但作为交换,你将获得完全的提供商独立性。

如何选择:为你量身定制的 AI 编程助手

你的工具应该为你服务,而不是反过来。以下是如何做出选择的指导:

适合 Claude Code 的场景

- 你希望获得 Anthropic 官方提供的、高度优化的体验。

- 你拥有 Claude Pro 或 Max 订阅,并希望最大化其价值。

- 你的安全团队需要一个他们认可的供应商名称。

- Claude 模型已经能够满足你 100% 的需求。

- 你偏好简洁、开箱即用的解决方案。

适合 OpenCode 的场景

- 你偏爱开源软件,可以审计、分支或修改。

- 你需要多种选择:为隐私而选择本地模型,或切换提供商以节省成本。

- 你是高级用户,需要对上下文限制和 Agent 定义进行细粒度控制。

- 你需要你的认证状态在不同工具之间持久化。

- 你喜欢探索和自定义你的开发环境。

坦白说,两者都是可靠的选择。这取决于你是更喜欢一个精心打理的“围墙花园”,还是一个广阔开放的“公共公园”。

视觉盲区:终端 AI Agent 的局限性

问题是:终端 AI Agent 在处理文本方面非常出色。脚本、配置、后端路由?它们轻而易举。但它们对你的应用看起来如何一无所知。当你告诉 CLI “修复移动端边距”时,它是在基于概率进行猜测,而不是实际观察。

你可以尝试通过像 Figma MCP server 或 Chrome DevTools MCP 这样的工具来弥补这一点。是的,它们可能有效,但感觉就像是临时修补。即使有截图和 DOM 检查,最困难的部分仍然是溯源:可靠地将 UI 更改追溯到产生它的确切组件和源代码行。

解决这个问题的一个方法是:将溯源作为一项核心功能,而不是一个尽力而为的工作流。 Builder 会对你的应用进行检测,以便编辑器可以将 UI 元素追溯到生成它的组件和源代码行。

它连接到你的 GitHub 仓库并启动一个真实的开发服务器。从那里,你可以获得一个类似 Figma 的可视化编辑器,直接在你的代码库上操作。拖动一个组件,调整间距,修改颜色。你不是在将像素推送到设计文件,而是在编辑源代码。它读取你现有的设计 Token 和组件,因此更改与你的系统保持一致。完成后,你会得到一个最小化的差异(diff)和一个可审查的拉取请求(PR)。

所以,将你的终端 Agent 用于后端逻辑和测试,这些是文本推理的强项。但当你需要触及像素并实际看到结果时,请切换到可视化工具。

关于 Builder 如何与 Claude Code、Gemini CLI 和其他 Agentic IDE 进行更深入的比较,我写了另一篇综述文章。

总结

Claude Code 和 OpenCode 从不同角度解决了相同的问题。Claude 带来了高度优化的体验和“开箱即用”的生态系统感。OpenCode 则带来了开发者所钟爱的灵活性和开源透明度。

其潜在的关键差异在于成本/访问策略。Claude Code 将 Claude 捆绑在订阅中,这可能比按 API 费率计费便宜得多。OpenCode 则提供了选择性:使用你自己的 API 密钥、切换提供商、运行本地模型,或者支付像 OpenCode Black 这样的固定费用层级。

但不要将你的整个工作流都建立在任何订阅 OAuth 流程都能永远正常工作的基础之上。提供商策略的改变现在是常态。

因此,像选择任何其他工具一样对待这个选择:在你的真实代码库上运行两者。你的单体仓库(monorepo)中那些“幽灵般的”依赖链将在 30 分钟内教会你比任何基准测试表更多的东西。

当你需要验证这些 Agent 推送到生产环境的前端效果时,不妨尝试一下 Builder。它能为你提供终端窗口难以提供的可视化上下文。

关于

关注我获取更多资讯